Hallucinations en IA : qu'est-ce que c'est et comment les éviter ?

Découvrez ce que sont les hallucinations en intelligence artificielle, leurs causes dans les LLM comme GPT, Claude ou Grok, et des solutions pratiques pour 2025. Optimisez votre contenu SEO et GEO avec des IA fiables !

- Dernière modification

9 décembre 2025 - 6 minutes de lecture

Cela vous est forcément arrivé : vous posez une question simple à un assistant IA comme ChatGPT ou Grok, et recevez une réponse confiante mais totalement inventée. C’est ce qu’on appelle une hallucination en IA, un phénomène qui touche de plus en plus les modèles de langage avancés (LLM). Selon un article récent du New York Times, même les systèmes de “raisonnement” les plus récents, comme ceux d’OpenAI, produisent des erreurs plus fréquentes en 2025. En cette fin d’année 2025, avec l’essor des LLM comme Claude d’Anthropic ou Gemini de Google, les hallucinations deviennent un enjeu majeur pour les professionnels du web. Elles peuvent générer du contenu erroné, impactant la fiabilité de vos stratégies SEO et GEO. Dans cet article, nous explorons ce concept, ses causes, et comment l’atténuer pour booster votre visibilité en ligne. Vous vous demandez comment protéger votre entreprise de ces pièges ? Plongeons dans le sujet pour transformer cette vulnérabilité en opportunité.

Les hallucinations se produisent de plus en plus souvent dans les réponses des LLM. On ne sait pas toujours pourquoi.

Définition des hallucinations en Intelligence Artificielle

Une hallucination en IA désigne une réponse générée par un modèle qui semble plausible mais qui est factuellement incorrecte ou inventée. Contrairement à une simple erreur, elle est présentée avec assurance, comme un fait avéré. Par exemple, un LLM comme GPT-4o pourrait affirmer que “Paris est la capitale de l’Allemagne” en toute confiance, en s’appuyant sur des patterns mal interprétés de ses données d’entraînement.

Ce terme, emprunté à la psychologie, s’applique particulièrement aux grands modèles de langage (LLM) tels que Grok 4 d’xAI, Claude 3.5 d’Anthropic ou Gemini 2.0 de Google. En 2025, avec l’intégration croissante de l’IA dans les outils quotidiens, ces hallucinations touchent des domaines variés : rédaction de contenu, analyse de données, ou même optimisation SEO. Selon IBM, elles surviennent lorsque le modèle perçoit des motifs inexistants, menant à des résultats absurdes.

Pourquoi est-ce problématique ? Dans un contexte SEO, un contenu généré par IA avec des hallucinations peut pénaliser votre site via les mises à jour Google comme le Helpful Content Update, qui priorise l’exactitude et l’EEAT (Experience, Expertise, Authoritativeness, Trustworthiness).

Évolution du Concept en 2025

En 2025, les hallucinations ne se limitent plus aux textes. Avec les modèles multimodaux comme ceux de Google ou OpenAI, elles affectent aussi les images et vidéos générées. Un article de Nature propose une classification complète des distorsions en IA, soulignant leur croissance exponentielle. Des discussions récentes sur X (anciennement Twitter) montrent même des cas où Grok détecte ses propres erreurs, un pas vers l’auto-correction.

Causes principales des hallucinations dans les LLM

Les hallucinations ne sont pas des bugs aléatoires ; elles découlent de limitations inhérentes aux LLM.

Premièrement, la surconfiance des modèles : ils génèrent des réponses avec une certitude excessive, même sur des sujets mal couverts par leurs données d’entraînement. Par exemple, si un LLM comme Claude manque de données récentes, il “invente” pour combler les lacunes.

Deuxièmement, les biais dans les données : les ensembles d’entraînement, souvent issus d’Internet, contiennent des inexactitudes amplifiées par l’IA. Une étude de Mila explique que cela ralentit l’adoption des LLM en entreprise.

Troisièmement, la complexité croissante : En 2025, les modèles “raisonnants” comme ceux d’OpenAI hallucinent plus, sans que les développeurs n’en comprennent pleinement les raisons. Enfin, les prompts mal formulés peuvent forcer l’IA à adopter une “personnalité” biaisée, menant à des simulations erronées, comme le note Andrej Karpathy sur X.

- Données incomplètes : manque d’informations actualisées post-entraînement.

- Sur-généralisation : le modèle applique des patterns erronés.

- Absence de contexte réel : les LLM simulent sans “comprendre” le monde.

Impacts sur le SEO et le GEO en 2025

Pour le webmarketing, les hallucinations posent un défi majeur en SEO. Un contenu IA erroné peut dégrader votre ranking Google, car les algorithmes pénalisent les infos inexactes. En GEO (Generative Engine Optimization), où les LLM comme Gemini génèrent des réponses directes, une hallucination pourrait exclure votre site des citations IA, réduisant le trafic de 30-50% selon des prévisions Ahrefs.

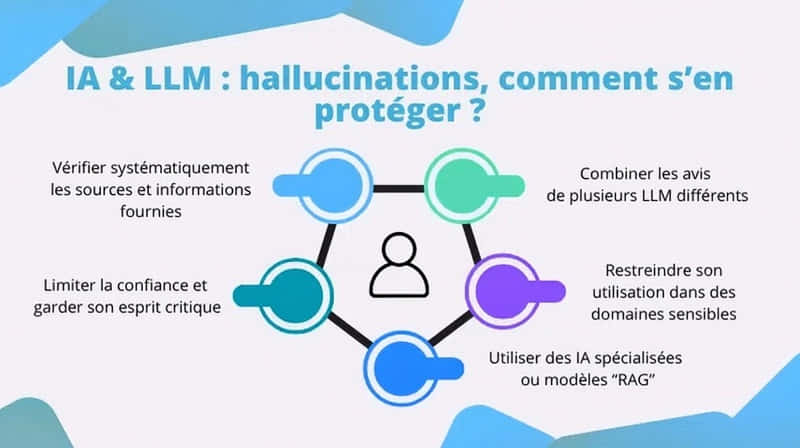

Stratégies pour réduire les hallucinations : solutions pratiques

Heureusement, des solutions émergent. La Retrieval-Augmented Generation (RAG) intègre des données externes pour ancrer les réponses dans des faits vérifiés. OpenAI recommande le fine-tuning sur des datasets spécifiques pour minimiser les erreurs.

Voici ce que vous pouvez faire concrètement pour éviter les hallucinations :

- Utilisez des prompts précis : Ajoutez “base-toi sur des faits vérifiés” pour guider l’IA.

- Intégrez la vérification humaine : relisez toujours le contenu généré.

- Adoptez des outils hybrides : comme Perplexity, qui combine recherche web et LLM.

- Monitorez avec des benchmarks : testez plusieurs LLM avec la même demande